1. Introdução

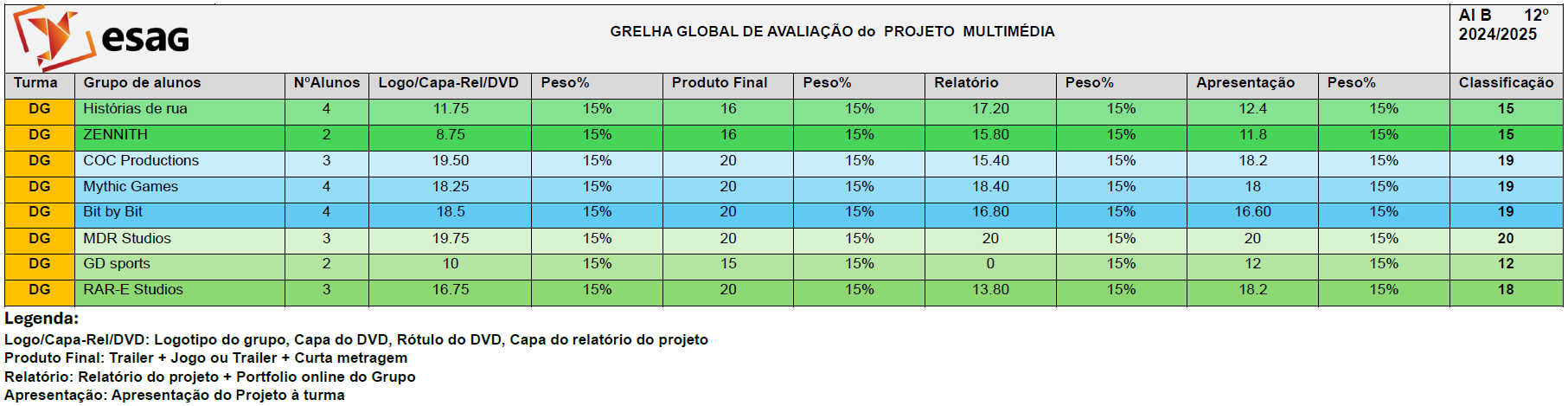

Este documento resume a avaliação dos projetos multimédia desenvolvidos pelos alunos da turma 12ºEF, no ano letivo 2021/2022. Os trabalhos foram avaliados com base em quatro componentes principais:

- Imagem (logo, capas de DVD e relatório, peso: 15%)

- Projeto (jogo ou filme, peso: 55%)

- Relatório (estrutura, conteúdo e formatação, peso: 15%)

- Apresentação oral (clareza, interação e recursos visuais, peso: 15%)

Além disso, foi considerada a heteroavaliação (avaliação entre pares) e autoavaliação dos alunos.

A grelha de avaliação apresenta os resultados dos projetos multimédia desenvolvidos por grupos de alunos, abrangendo critérios como imagem, projeto, relatório e apresentação oral. Os projetos foram avaliados em diferentes categorias, com pesos específicos para cada componente, resultando numa classificação final.

Principais Observações:

- Projetos Destacados:

- MDR Studios e Mythic Games obtiveram as melhores classificações (20 e 19 valores, respetivamente), com elogios à organização, criatividade e qualidade dos trabalhos apresentados. O grupo MDR Studios destacou-se pela apresentação bem estruturada e pelo trailer apelativo.

- COC Productions e Bit by Bit também receberam avaliações positivas (19 e 18 valores), com menções à originalidade e ao esforço na execução, embora com algumas falhas pontuais, como problemas de formatação ou falta de detalhes em anexos.

- Pontos a Melhorar:

- Alguns grupos, como ZENNITH e Histórias de Rua, tiveram avaliações mais baixas (15 valores) devido a problemas como falta de ilustrações, demonstração inadequada do jogo ou relatórios incompletos.

- O grupo GD sports foi o menos avaliado (12 valores), com críticas à falta de cumprimento de requisitos e à apresentação pouco elaborada.

-

Avaliação por Componentes:

-

Relatório: Os melhores relatórios foram os dos grupos MDR Studios (20 valores) e Mythic Games (18.4 valores), que se destacaram pela clareza, detalhe e organização. Problemas comuns incluíram falta de ilustrações, cronogramas mal elaborados e bibliografias incompletas.

-

Apresentação Oral: As apresentações mais bem avaliadas foram as dos grupos MDR Studios (20 valores) e RAR-E Studios (18.2 valores), que conseguiram transmitir as ideias com clareza e interagir com a audiência. Outros grupos tiveram dificuldades em demonstrar os projetos ou evitar a leitura de slides.

-

-

Heteroavaliação:

-

Os alunos avaliaram os colegas de forma geralmente consistente com as notas dos professores, destacando os mesmos grupos (como MDR Studios e Mythic Games) como os mais bem-sucedidos.

-

-

AVALIAÇÃO ESPECÍFICA DO RAR-E STUDIOS (12ºDG)

Classificação Final: 18 valores (Turma 12ºDG)

Pontos Fortes:

-

✔ Filme com qualidades técnicas destacadas: música de fundo adequada, flashbacks bem executados e final criativo

-

✔ Elementos narrativos originais: personagem com máscara e voz transfigurada gerou interesse

-

✔ Trailer avaliado como “MB” (Muito Bom) na apresentação oral

-

✔ Audiência envolvida durante a apresentação (silêncio e atenção)

Pontos Fracos:

-

✖ Falta de apoio visual: não utilizaram PPT para organizar ideias

-

✖ Site incompleto: não disponibilizou a curta-metragem

-

✖ Capa do relatório não correspondeu à qualidade do projeto

-

✖ Anexos em falta: planeamento e cronograma não entregues

Desempenho por Componentes:

-

Projeto (Filme): 18.31 valores

-

Relatório: 13.8 valores (pontuação mais baixa)

-

Apresentação Oral: 18.2 valores

-

Heteroavaliação Média: 19.5 valores (entre pares)

-

Conclusão:

Os projetos demonstraram variação significativa na qualidade, com alguns grupos a destacarem-se pela excelência e outros a necessitarem de melhorias na organização, execução e apresentação. A criatividade e a atenção aos detalhes foram fatores determinantes para as melhores avaliações. Recomenda-se maior rigor no cumprimento dos requisitos e na preparação das apresentações para futuros trabalhos.